El mes pasado los que leyeron el artículo fueron objeto de un test de emailing. Unos recibieron un email y otros el mismo email pero con un pequeño cambio, que ha tenido consecuencias. En este artículo explicamos qué se cambió, cuál ha sido el resultado y cómo se ha hecho el test.

Qué se cambió

Antes de correr a ver los resultados, te propongo otro test.

Sé que sabes mucho de marketing y quiero que lo demuestres: ¿qué versión de email funcionó mejor?

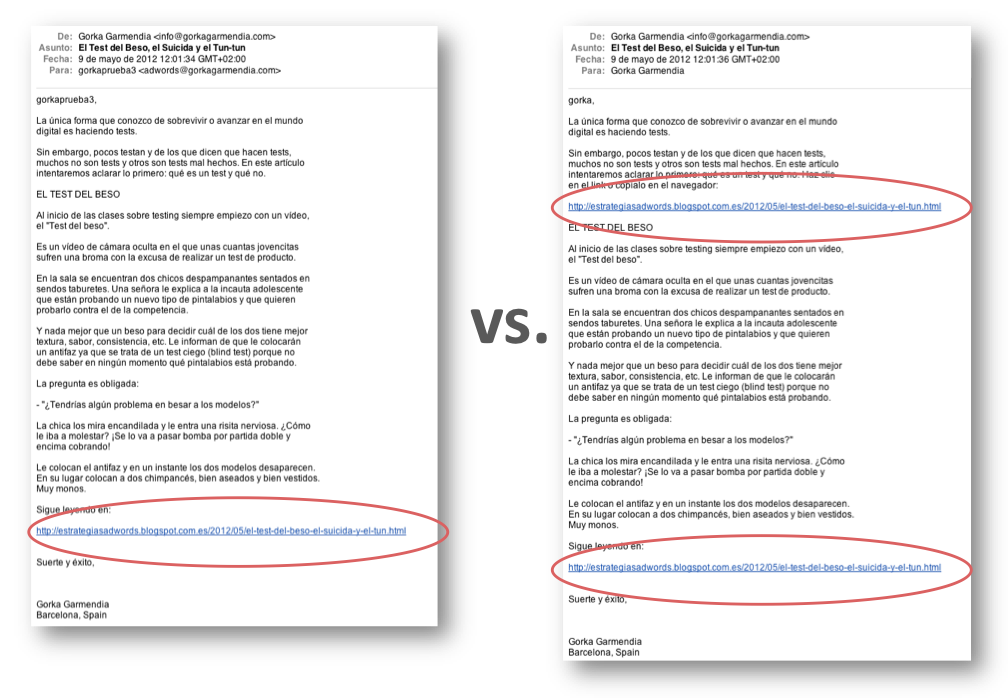

Mira los dos emails del test. No hace falta que los leas. El cambio es pequeño pero evidente:

And the winner is…

¿Cuál funcionó mejor? ¿Poner un solo link al final o añadir otro al principio?

Pues todavía no te lo puedo decir. Veamos primero cómo se hace un test y en unas líneas desvelamos el resultado.

Las fases de un testing A/B son:

- El objetivo del test

- La hipótesis

- Hawthorne is missing

- Ceteris Paribus

- Ejecución y resultados

- Validación estadística

- Masivo o roll-out

1. El objetivo del test

Si hacemos un test invertimos tiempo y dinero, así que hay que rentabilizarlo.

Si no fijamos un objetivo no sabremos si ha valido la pena.

Se trata por lo tanto de elegir una métrica o métricas y plantear una mejora.

Por ejemplo, en el caso del test “1 link vs. 2 links”, el objetivo es mejorar el ratio de apertura (OR, Open Rate) y sobre todo, el ratio de clic (CTR, Click Trough Rate) un 10%.

2. La hipótesis

La hipótesis del test es la suposición que hacemos y que el mercado, es decir, el usuario, nos dirá si teníamos razón o no.

En el ejemplo, la idea a testar es muy sencilla: ¿es mejor uno o dos links hacia la landing page?

En principio cuanto más veces pides una respuesta, más respuesta obtienes. Dos links debería ser mejor opción.

Además, la versión que sólo tiene un link al final del email, puede pecar de exceso de confianza porque muchos no llegan tan lejos. Podría ser mejor aprovechar el interés desde las primeras líneas y colocarles un link bien arriba, antes de que ese preciado interés se disipe.

Una vez creados las dos versiones, se montan en la plataforma de envío de emailings, la cual debe tener incorporada la funcionalidad del testing y entre otras cosas, garantizar que el “Efecto Hawthorne” no se va a producir.

3. Hawthorne is missing

Como veíamos en el artículo del mes pasado, si le enseñamos las dos versiones de email a alguien para que nos diga cuál le haría abrir y clicar más, estaremos bajo el influjo maligno del Sr. Hawthorne.

Nuestro conejillo de indias sabe que lo es, y por lo tanto no podrá ser 100% objetivo, variará su respuesta porque querrá complacernos y el resultado no será válido.

Por lo tanto, el usuario no debe saber que está siendo objeto de un test.

Con una plataforma de emails que tenga una buena herramienta de testing esto se solventa de forma muy sencilla: la maquinita nos hace una separación automática de la lista para el test, una porción que debe ser lo más pequeña posible.

Esta separación se divide a su vez en dos (por eso se llama ‘split’ testing), por ejemplo, 50% y 50%.

A cada mitad le envía una de las versiones y sólo una; recopila los datos de apertura y clic, y lo coloca en cada versión para poder hacer el seguimiento de resultados una vez acabado el test.

4. Ceteris Paribus

Este latinajo, que les será familiar a los que han estudiado Económicas o Empresariales, significa algo así como “todos quietos” o “en igualdad de condiciones”.

Aplicado al testing nos avisa de que cuando hacemos un tests todo tiene que quedar igual excepto una cosa, lo que se testa.

En el test que estamos viendo, todo es lo mismo: el texto del email, la base de datos a la que se le envía, la landing page de destino, el momento en que se envía… todo excepto el cambio objeto del test: uno tiene un link, el otro dos.

Si no respetamos esta regla, el test no se invalida del todo pero ya no sabemos qué cambio ha provocado qué resultado. Sólo sabremos que un email ha ido mejor que el otro, pero no porqué. Lo cual en muchos casos puede ser un gran error.

5. Ejecución y resultados

En el caso de un test de emailing es muy sencillo. Le damos al botón de “send” o bien programamos el envío y esperamos.

En 24 horas la suerte está echada. En este caso hemos esperado casi un mes, así que seguro que hemos recogido todos los datos de los rezagados.

Los resultados han sido:

- Ratio de apertura: la versión A (un link) mejora a la B (dos links) en un 11%

- Ratio de clic (CTR): ambas versiones generan el mismo CTR.

6. Validación estadística

¿Verdad que si tengo un comercial que hoy ha traído dos pedidos y otro vendedor sólo un pedido no puedo decir que el primero es el doble de mejor que el segundo?

Tendré que juzgarlos con más tiempo, es decir, tendré que ampliar la muestra para poder decir que el dato es cierto y así poder tomar la decisión de subirle el sueldo a uno y ver si el otro sigue en el puesto.

En testing ocurre lo mismo. Si no tengo lo que se llama “confianza estadística” o “relevancia estadística” o términos similares, no tengo nada.

Para ello el primer paso es contar con una muestra suficientemente grande. De lo contrario, el resultado del test será no válido, hemos hecho el primo.

Lo segundo es contar con alguna herramienta que te calcule el dato de confianza estadística.

En el pasado esto era algo complicado, tenías que dominar de estadística o saber consultar unas farragosas tablas tan user-friendly como los formularios de Hacienda.

Pero hoy, gracias a la era digital, esta tarea es simple. Hay multitud de herramientas en Internet que te lo calculan gratis o casi gratis y en décimas de segundos.

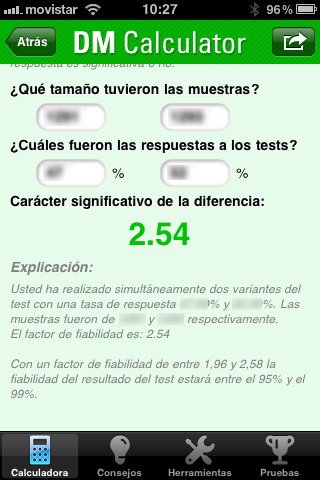

En el ejemplo del test “1 link vs. 2 links”, hemos utilizado una App para iPhone, la “DM Calculator” (http://itunes.apple.com/es/app/dm-calculator/id473692072?mt=8) y hemos introducido los datos de open rate (ya que los de CTR no han reflejado cambios).

El resultado es el siguiente:

Como dice la herramienta, tenemos una fiabilidad de entre el 95 y el 99%, que en la mayoría de los casos es más que suficiente.

Por lo tanto, la mejora del 11% en aperturas de la versión de “un solo link” es consistente, nos la podemos creer, no es resultado del azar. Lo más importante, podemos exprimir el resultado en el siguiente paso:

7. Masivo o roll-out

Una vez el test nos ha indicado el camino, es momento de seguirlo.

La versión ganadora se envía el resto de la base de datos, es decir se hace el masivo o “roll-out”, con la seguridad de que se va a repetir el resultado ya que contamos con la confianza estadística del punto anterior.

Conclusiones del testing de email

El test fue hecho con la convicción que de se mejoraría el CTR con dos links, ya que los estudios afirman que así es cuando insertamos más links en un email. El Open Rate se esperaba que no cambiaría.

Sin embargo, el CTR no ha variado y lo que es más, lo que ha variado es el ratio de apertura, justo al revés.

Los tests tienen esto, son impertinentes, les encanta llevarte la contraria. No es la primera vez que ocurre ni será la última.

No pasa nada, ya sabemos algo. Podemos tomar nota de lo que a otros les va bien, pero aceptarlo sin más es cuando menos, arriesgado. Siempre hay que comprobar si en MI sector, MI producto y MI público objetivo las best-practices también son best-practices.

Ahora bien, con este test sabemos el QUÉ pero no el POR QUÉ.

Los motivos que ha llevado a la gente a abrir más un email con un solo link no los podemos extraer del test, sólo podemos hacer conjeturas.

Yo tengo una teoría, ¿cuál es la tuya?

Antoine

junio 1

Quizas porque ...

- El primer enlace era demasiado cerca del principio del texto, insuficiente para que el usuario este enganchado por la historia?

- La llamada a la accion del primer enlace "Haz clic en el enlace o copialo en el navegador" es mejorable?

Has demostrado lo importante de los tests con uno que demuestra lo opuesto de lo que pensaba!

Muy bien hecho! 😉

Globalgi

junio 5

Coincido en parte con Antoine, pero no solo porque el link estaba demasiado pronto, sino porque el mensaje inicial no tenia tanta fuerza para crear la atención de "hacer click" en el link, sin embargo el mensaje del "test del beso" es el que tiene la capacidad y la fuerza suficiente para llamar la atención del lector de forma imaginativa y diferente. Creo que el éxito del link proviene de la creatividad del mensaje que lo precede.

Ejemplo 1: He hecho un test técnico - sigue leyendo ....

Ejemplo 2: Erase una vez .... bla bla bla ..... - sigue leyendo ...

El éxito está en la originalidad de tus comunicaciones .... Felicidades!!

Sigue así.

Un saludo

Carmen Molina

junio 5

Muy interesante el estudio. Yo creo que el título del mensaje es suficientemente intrigante pero sin dar demasiadas pistas, por lo que antes de lanzarte a un click de impulso parece que te motiva más leer un poco de qué va la cosa para luego bucear. Supongo que la diferencia estribará en parte en eso: en si buscamos una actuación por impulso, en cuyo caso el link debe estar cercano para que se clicke antes de que el lector se canse o si buscamos pescar a un cliente o usuario de opinión, en cuyo caso conviene despertar su curiosidad y que tenga ganas verdaderas de leer más. ¿Qué os parece?

buscodescargas

junio 5

Encantado de haber sido un conejillo de indias en tu estudio!!

La verdad es que me han sorprendido los resultados; la respuesta obvia, como dices arriba, es que tuviese más éxito el mail con dos enlaces, pero los resultados han evidenciado el triunfo de lo contrario. Quizá con otra llamada a la acción en el primer link el resultado hubiera sido diferente.

La versión de dos enlaces me gusta más.. los hay que no queremos esperar a leer el mail completo para averiguar de qué nos están hablando, o proponiendo, desde la misma landing page ya que en ella debe haber más información.

Respecto a los cambios en la página, decir que ha mejorado un montón. Por lo que a mi respecta el tiempo de carga ha disminuido una eternidad, gracias

Saludos

Josep

Rafa Tejada

junio 5

Sin leer -ni recordar - el contenido de ambos correos , creo que todo tiene que ver con una percepción cualitativa : si te llega un correo de Gorka supones que es algo interesante , si tiene "demasiados" links parece algo más comercial ( te pongo varios cebos para que piques ). Un sólo link puede resultar aceptable como parte de la argumentación. Para hacer desaparecer totalmente al señor Hawthorne no debería aparecer Gorka como remitente.

Anónimo

junio 7

En mi caso también opino lo mismo.

Debería desaparecer el nombre de Gorka y eso sería otra cosa.

Yo por lo menos, casi seguro que ni lo abriría

Sergi

junio 5

Interesante testing, efectivamente yo también hubiera dicho que el de dos enlaces tendría más aperturas. Pero aún con eso yo creo que depende también del tipo de e-mailing, si es comercial es recomendable poner al principio nombre e imagen de la empresa y el link de su web. Me llamo Sergi y trabajo para una empresa que proporciona un programa de e-mailing (que permite este tipo de tests), Sarbacán Software, y cuando asesoramos a nuestros clientes les insistimos en que pongan arriba y de forma visible el enlace a su web. Pensad que la mayoría son empresas que se inician en el e-mailing y que tampoco tienen un contenido muy atractivo, ni sus destinatarios están acostumbrados a recibir sus e-mails...por eso creemos que es mejor que pongan enlaces, no se que pensáis... Y ya que apuesto por poner links, aquí os dejo el de nuestro blog http://blog.sarbacan.es/ y el de la nuestra web http://www.sarbacan.es/

nuria

junio 5

Coincido con los comentarios anteriores, el link estaba demasiado pronto y el mensaje no tenía fuerza suficiente para despertar la atención ... "la curiosidad mató al gato"

Muy interesante el estudio y la redacción del artículo en el que lo explicas, enhorabuena por las mejoras de la página.

Racmar

junio 5

Pues si que se te da bien eso de mostrar y demostrar al unísono. Muchas gracias por este post. Una forma muy didáctica de mostrar, una vez más, que no podemos asumir nada, solo testar.

Saludos,

Racmar

Miguel

junio 6

Personalmente pienso que si Gorka, me envia un email con 1,2,3,...10 links en el mensaje los pinchare 🙂

Y si me envia un email sin enlaces, me veo capaz de escribirle un email preguntando por el enlace que me falta 😛

¿Porque? muy simple. Por que ya tienes una reputación ganada. ¿PORQUE? cada día o mejor dicho una vez por mes 🙂 me llega un mensaje tuyo donde se que voy a encontrar contenido relevante para mí, y eso rompe todas las estadísticas y testings....

Sigue así y te seguiremos 🙂

GRACIAS

Josep Garcia

junio 7

Hola Gorka,

mi teoría es mucho más simplona. Quien está suscrito a tu lista es porque le interesa lo que cuentas. Cuando recibimos un e-mail tuyo, lo leemos (o al menos, ese es mi caso).

Es sencillo, el primero lo abrí, y lo leí. El segundo...era el mismo? Pensé que fue un fallo de tu servidor de correo, eso es todo. Vi que el subject era el mismo, debía tratarse de un error.

Yo habría enviado una versión a la mitad de la lista y la segunda versión a la otra mitad. De ahí podrías haber sacado una mejor foto, o eso creo.

En cualquier caso, no dejes de escribir, de hacer pruebas y de compartirlas con nosotros/as.

Gracias,

Josep

Gorka Garmendia

junio 7

Josep, no es un error del servidor ni de la plataforma de emailing. Es un fallo nuestro. Lo más seguro es que tengamos dos direcciones de correo tuyas en la base de datos y por eso has recibido dos y no uno. Tenemos que limpiar la base de datos y en casa del herrero ya se sabe...

Pablo Iglesias

junio 7

Me parece increíble que varíe la apertura pero no el CTR por el número de links, no tiene sentido. :-O

Sólo se me ocurre que por la previsualización en clientes de escritorio (tipo Outlook) no vean ningún link y como les parece interesante la introducción abran el email para ver más o buscar el link.

Otra teoría sería una cuestión de entregabilidad, pero por el tipo de emails que envías, sinceramente, no creo que se quede en un filtro antispam por un miserable link.

En cuanto a los tests, sí que son una fuente de sorpresas, no hace mucho hice uno sólo variando el orden del asunto que también me dejó a cuadros.

El resultado:

1- "Consigue tal a un precio cual y con este beneficio" ~30% OR ~20% CTR

2- "Consigue tal con este beneficio y a un precio cual" ~45% OR ~10% CTR

Saludos

Por cierto, estupendo newsletter y estupendo blog. 🙂

Gorka Garmendia

junio 7

Muy interesante el test de asunto: hay que buscar un equilibrio entre cantidad y calidad, no quedarse sólo con los OR. Gracias por compartirlo !

Gustavo Dost

junio 7

Que interesante ya habría jurado que tenia mas clic el email con dos enlaces... increíble.

Creo que otra variable interesante de probar son los "asuntos" de los correos. Un buen titular tiene que genera no solo mas "lecturas" si que también más clic. ¿Puede ser?

Lena

junio 9

Pues mi teoría sería, que una empresa cuanto más halla segmentado su target, tendra un porcentaje "x" a su favor de no tener que emplear recursos o herramientas que le aseguren la visibilidad. Pero para llegar a esto la empresa debe conocer de los intereses, intenciones, expectativas, etc el perfil de sus clientes.Haber invertido mas que dinero, creatividad y tiempo.

¡Gracias Gorka!

caos30

junio 12

1. Muy didáctico tu artículo y tu estilo. Felicidades!

2. Sigo pensando q ha interferido algo en tu test, no sé si como alguien dijo arriba algún filtro anti-spam o por algún problema técnico o mala configuración del sistema de medida o tracking. Lo pienso principalmente porque "psicológicamente" hablando este resultado INVERSO no tiene sentido. La igualdad de CTR ya me parece más normal, pero¿más clics con un solo enlace? según me dicta la lógica este aparente comportamiento de tus lectores sugiere que una fracción significativa de ellos HA DEJADO de hacer clic por haber visto el enlace al principio???

Uno se pregunta entonces:¿este grupo de usuarios abandonaron antes la lectura?¿o leyeron hasta el final en igual proporción q el otro grupo y simplemente les convenció menos el artículo POR EL PRIMER ENLACE?

Ninguna explicación parece razonable para explicar este resultado inverso.

Saludos!

SERGI

Juan Carlos

marzo 7

Hola, hablo solamente a partir de la lectura de estos resultados, ya que soy "nuevo" y no recibí estos test. Pero mi primera impresión es sencilla: si tienes un solo enlace, solo tienes 2 opciones (o pinchas o no pinchas, es decir, o blanco o negro), pero si tienes 2 enlaces, hay una opción más y determinante, "la duda", y si dudas es más fácil no pinchar.

Saludos;

Juan Carlos

Heatmaps o mapas de calor - Gorka Garmendia

mayo 1

[...] 1. Significancia: un heat map es como un cuadro impresionista de esos de puntitos. Necesita miles para ver algo, así que si colocas el seguimiento en una página que recibe pocas visitas, es como si al pintor le pides que haga un cuadro con sólo unas pinceladas. No se formará la imagen y tardará demasiado tiempo, con lo que la significancia del resultado será baja (idem en el caso de los tests A/B). [...]